Récap techno Spiria - № 371 - Nvidia H100 NVL, ChatGPT sur MS-DOS, Framework 16, GitHub Copilot X, etc.

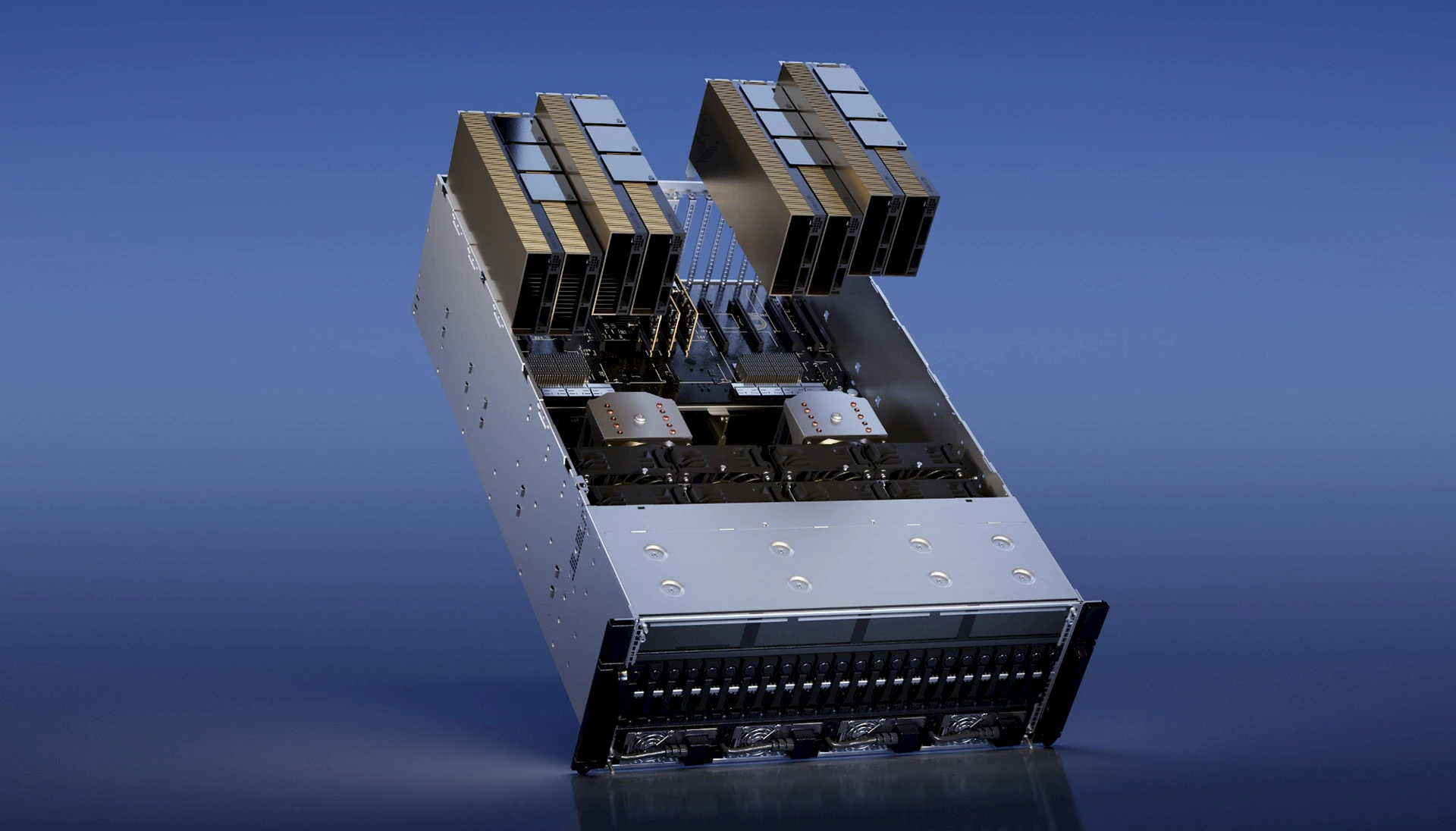

Une carte bi-GPU avec 188 Go de mémoire vive !

H100 NVL. © Nvidia.

Les grands modèles de langage (LLM) sont très gourmands en mémoire et en puissance de calcul, et leur succès amène les fabricants de GPUs à concevoir des produits qui leur sont spécifiquement dédiés. Ainsi, Nvidia a présenté la H100 NVL, qui est constituée de deux cartes PCIe H100 unies par un pont (connexions NVLink 4) et est équipée d’une quantité de mémoire hors norme : 188 Go de RAM HBM3. En outre, la bande passante globale de la carte est de 7,8 To/seconde. Nvidia annonce que la H100 NVL offre un débit d’inférence GPT3-175B (175 milliards de paramètres) 12 fois supérieur à celui d’un HGX A100 de dernière génération. Comme il s’agit d’une solution constituée de deux cartes, chaque H100 NVL occupe un espace de deux slots. Ces cartes commenceront à être livrées au cours du second semestre de cette année. La société n’a pas indiqué de prix, mais on sait que ça va coûter cher (comptez plusieurs dizaines de milliers de dollars). L’explosion de l’utilisation des LLM est en passe de se transformer en une nouvelle ruée vers l’or pour le marché des GPU pour serveurs.

Par ailleurs, Michael Kagan, directeur de la technologie chez Nvidia, a récemment déclaré au Guardian que les cryptomonnaies n’apportaient “rien d’utile à la société”. “Je n’ai jamais cru que [les cryptomonnaies] pouvaient apporter quelque chose de bon à l’humanité. Vous savez, les gens font des choses folles, mais ils achètent vos produits, vous leur vendez des produits. Mais vous ne réorientez pas l’entreprise pour soutenir ce qu’ils font.” Nvidia n’a jamais accueilli la communauté cryptographique à bras ouverts. En 2021, l’entreprise a même imposé un système qui limitait artificiellement la possibilité d’utiliser ses cartes graphiques pour miner la populaire cryptomonnaie d’Ethereum, dans le but de s’assurer que ses produits disponibles aillent plutôt à ses clients favoris, comme les chercheurs en IA et les joueurs.

⇨ AnandTech, Ryan Smith, “NVIDIA Announces H100 NVL - Max Memory Server Card for Large Language Models.”

⇨ Tom’s Hardware, Jarred Walton, “Nvidia Is Bringing Back the Dual GPU... for Data Centers.”

2023-03-21

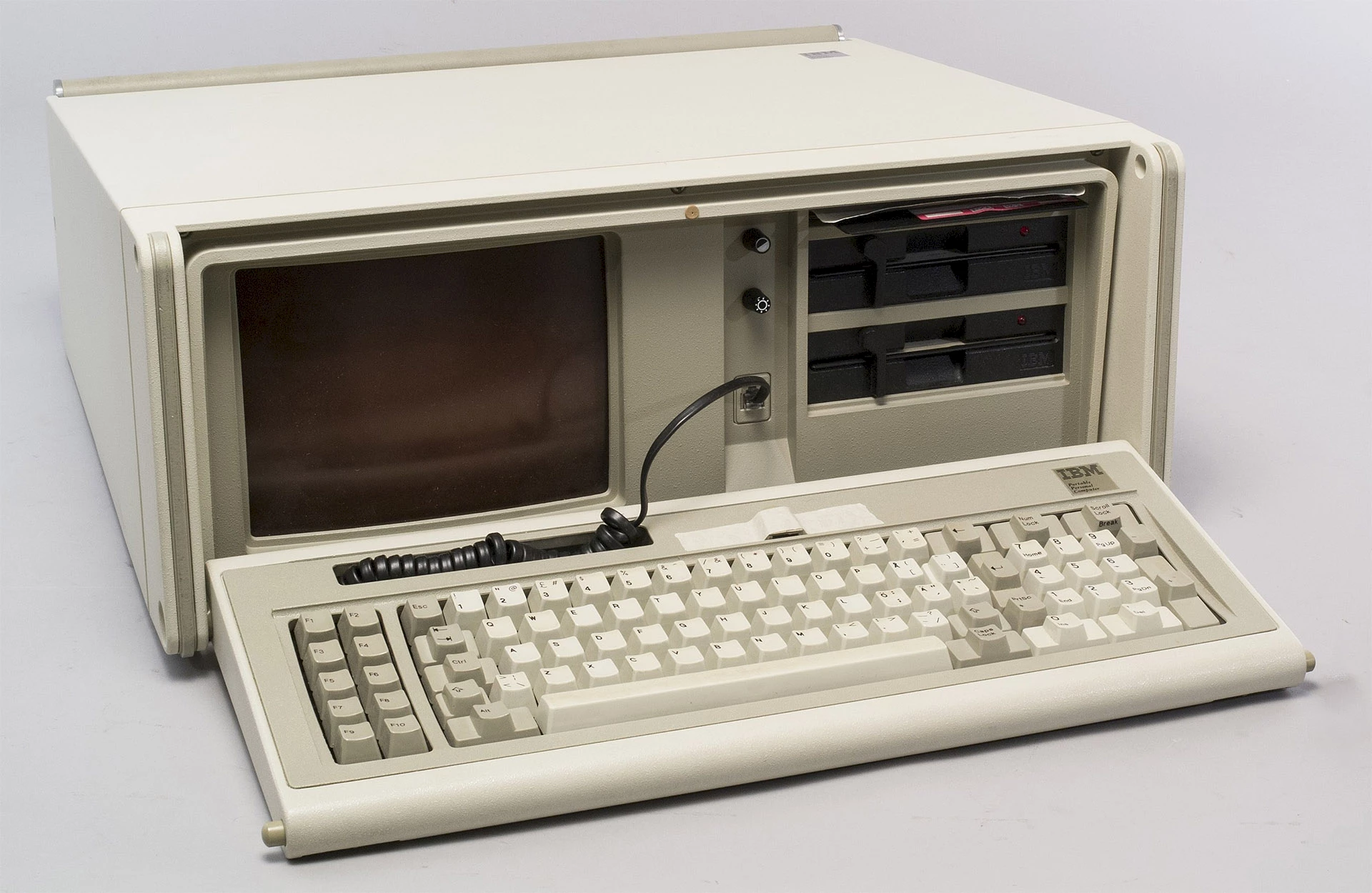

Un client ChatGPT pour… MS-DOS !

IBM 5155. Peter Böhm - CC BY 3.0.

Yeo Kheng Meng est un passionné de rétro-informatique basé à Singapour et on lui doit déjà un client Slack pour Windows 3.1. Aujourd’hui, il publie un client ChatGPT pour MS-DOS qui peut fonctionner sur un PC IBM cadencé à 4,77 MHz, offrant ainsi un moyen unique de converser avec le populaire modèle de langage d’OpenAI. Faire fonctionner ChatGPT sur des ordinateurs du début des années 1980 constituait tout un défi, autant par le manque de capacité native de mise en réseau que par la faible puissance de ces machines (Yeo a utilisé un PC portable IBM de 1984, doté d’un processeur Intel 8088 à 4,77 MHz et 640 Ko de mémoire). Le développeur a employé Open Watcom C/C++, un compilateur moderne fonctionnant sous Windows 11 qui peut cibler les plates-formes DOS 16 bits. Pour ajouter une couche réseau, il a dû avoir recours au PC/TCP Packet Driver, une API réseau inventée en 1983, et à une librairie d’utilitaires TCP/IP pour DOS développée par Michael B. Brutman. Dernier écueil, et non le moindre, les API de ChatGPT nécessitent des connexions HTTPS cryptées et il n’existe aucune librairie pour les gérer sur MS-DOS. Yeo a donc dû créer un proxy HTTP-vers-HTTPS qui peut fonctionner sur un ordinateur moderne et traduire les demandes et les réponses entre le client MS-DOS et l’API sécurisée de ChatGPT. À propos de ce “bricolage”, Yeo écrit sur son blogue : “Les puristes n’apprécieront peut-être pas cette solution, mais c’est le mieux que je puisse faire avec mes capacités dans un délai raisonnable.”

⇨ YouTube, “DOS ChatGPT client on a 1984 IBM Portable PC 5155”

⇨ Ars Technica, Benj Edwards, “Hobbyist builds ChatGPT client for MS-DOS.”

2023-03-23

Framework se prépare à lancer un portable 16 pouces

Framework 16. © Framework.

Après le succès de son portable modulaire 13 pouces (qui peut être réparé, modifié et mis à niveau par son utilisateur, et qui vient tout juste de bénéficier d’une possibilité de mise à jour 13e génération de son processeur Intel, ainsi que d’une toute nouvelle option AMD Ryzen), Framework annonce la prochaine sortie d’un portable 16 pouces. Ce modèle à plus grand écran peut accueillir des processeurs plus puissants, des GPUs dédiées et une gamme de modules de clavier différents, le tout avec la même promesse de réparabilité et d’évolutivité que celle du Framework Laptop original. Une particularité attrayante est une baie d’extension amovible, placée à l’arrière du portable, qui permet d’accueillir des modules GPUs au cas où vous ne voudriez plus de puissance graphique que celle offerte par l’unité GPU intégrée. Ces modules GPU utilisent huit voies de bande passante PCIe et peuvent être branchés et débranchés sans modifier quoi que ce soit d’autre sur l’ordinateur portable. Un concept bien intéressant, mais il faudra cependant faire preuve d’un peu de patience : les précommandes n’ouvriront pas avant “ce printemps” et les livraisons ne commenceront pas avant “fin 2023”.

⇨ Ars Technica, Andrew Cunningham, “Framework’s first gaming laptop features upgradeable GPUs, swappable keyboards.”

2023-03-23

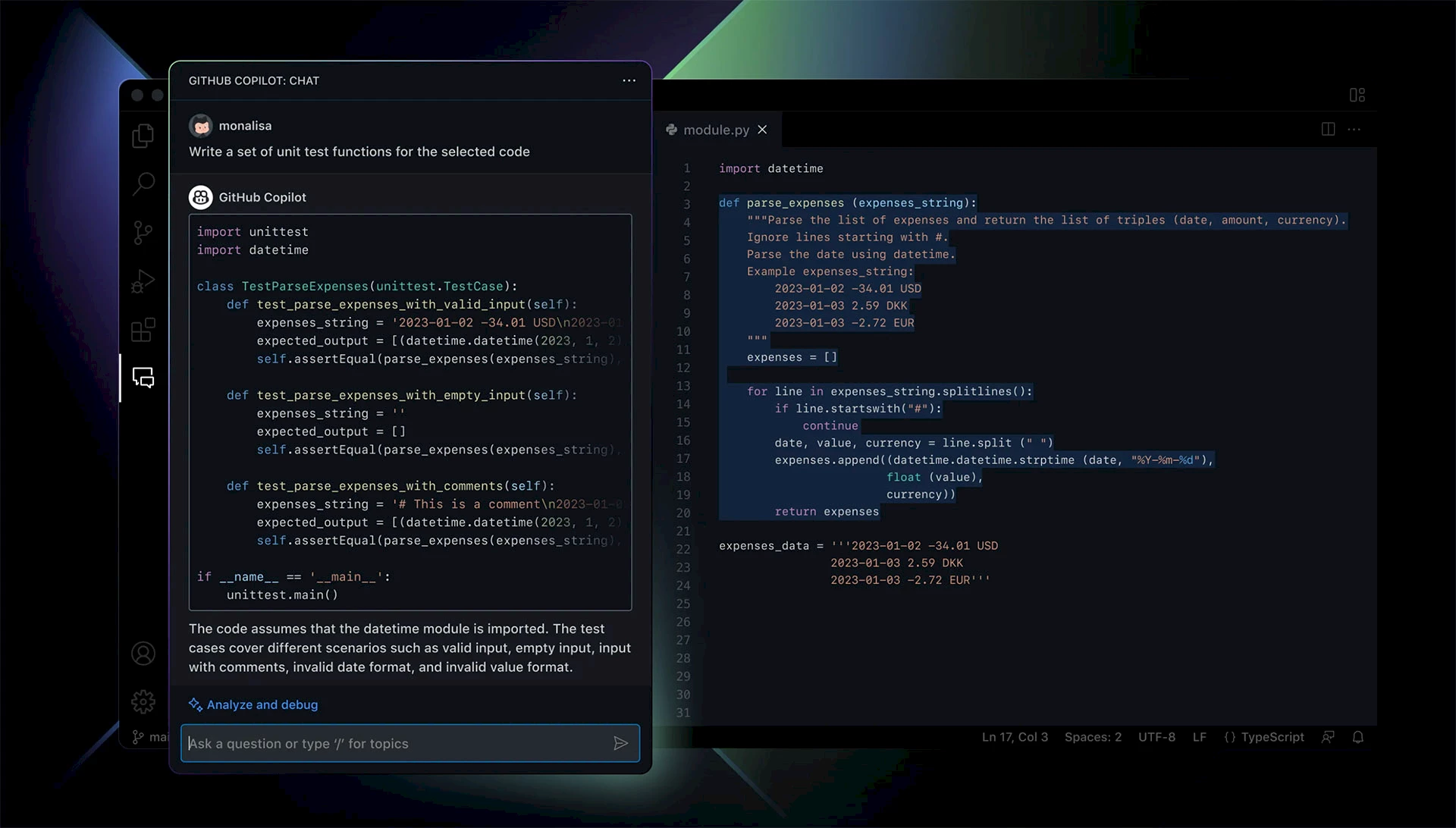

GitHub Copilot X

Copilot X. © GitHub.

GitHub, propriété de Microsoft, fait grandement évoluer son système Copilot afin d’intégrer le modèle GPT-4 d’OpenAI. Cette nouvelle version de l’outil d’aide à la programmation apporte un support vocal et un robot conversationnel à votre environnement de développement intégré (IDE). L’agent conversationnel est en mesure de reconnaître et d’expliquer le code, de recommander des modifications et de corriger les bogues. Ces nouvelles possibilités de l’outil vont bien au-delà de la simple autocomplétion intelligente de code et le rapproche davantage d’un véritable assistant de codage, à l’instar du nouveau Copilot de Microsoft pour les applications Microsoft 365. “Il s’agit d’une idée similaire au chat de Bing ou à la barre latérale de Microsoft Edge, mais en l’intégrant dans le flux de travail du développeur”, explique Thomas Dohmke, le PDG de GitHub. “Je pense que pour les développeurs, la différence entre GitHub Copilot et Bing est que Copilot se concentre sur le code. Vous pouvez lui demander de corriger votre code, de vous expliquer le code, et vous pouvez même lui demander d’écrire un test unitaire.” Aussi, avec le support vocal, vous n’aurez même plus besoin d’un clavier pour coder. Avec la fonction “Hey, GitHub!”, vous pourrez vous asseoir devant un PC et commander Copilot avec votre voix pour répondre à des questions ou suggérer des lignes de code. Et, bien utile, l’assistant peut vous trouver des réponses à jour dans toute la documentation React, Azure et MDN. Ce nouveau système Copilot X ne sera initialement disponible que dans les applications Visual Studio et Visual Studio Code de Microsoft, mais GitHub prévoit de l’étendre à d’autres IDE à l’avenir.

GitHub Copilot a déjà joué un rôle majeur dans la productivité des développeurs pour plus d’un million de personnes, aidant les développeurs à coder jusqu’à 55 % plus rapidement, selon GitHub. Thomas Dohmke pense que cela va encore augmenter avec ces nouvelles fonctionnalités de chat et que les assistants IA comme Copilot vont être fondamentaux dans la façon dont les gens apprennent à coder à l’avenir.

⇨ YouTube, “GitHub Copilot X”

⇨ The Verge, Tom Warren, “GitHub Copilot gets a new ChatGPT-like assistant to help developers write and fix code.”

2023-03-22

Microsoft, toujours plus verte

© CarbonCapture.

Microsoft, un important acteur dans le soutien aux technologies émergentes d’élimination des émissions de dioxyde de carbone de l’atmosphère, a accepté d’acheter des crédits d’élimination du carbone à CarbonCapture, une jeune entreprise basée à Los Angeles. CarbonCapture a mis au point une technologie modulaire qui aspire le CO2 de l’air ambiant pour le stocker sous terre, empêchant ainsi ce gaz à effet de serre de contribuer au changement climatique. Microsoft s’est fixé pour objectif de devenir “carbone négatif” d’ici à 2030, ce qui signifie qu’elle éliminerait de l’atmosphère plus de pollution par le CO2 qu’elle n’en génère par l’utilisation de combustibles fossiles. Cet accord aide Microsoft à atteindre son objectif de neutralité carbone, tout en contribuant à soutenir la croissance de l’industrie du captage direct de l’air dans son ensemble. CarbonCapture prévoit de capturer et de stocker 10 000 tonnes de CO2 par an après avoir déployé ses premiers modules dans le Wyoming l’année prochaine. D’ici à 2030, CarbonCapture prévoit de pouvoir éliminer 5 millions de tonnes de dioxyde de carbone par an.

⇨ The Verge, Justine Calma, “Microsoft inks another deal to capture and store its carbon emissions underground.”

2023-03-22